AnythingLLM安装及使用

安装

AnythingLLM下载地址: https://anythingllm.com/desktop

Ollama下载地址: https://ollama.com/

Ollama安装注意事项

改Ollama安装位置

由于Ollama的exe软件安装时候默认是在C盘,导致会占用C盘空间,

为了自定义Ollama的安装目录,可以按照以下步骤操作:

-

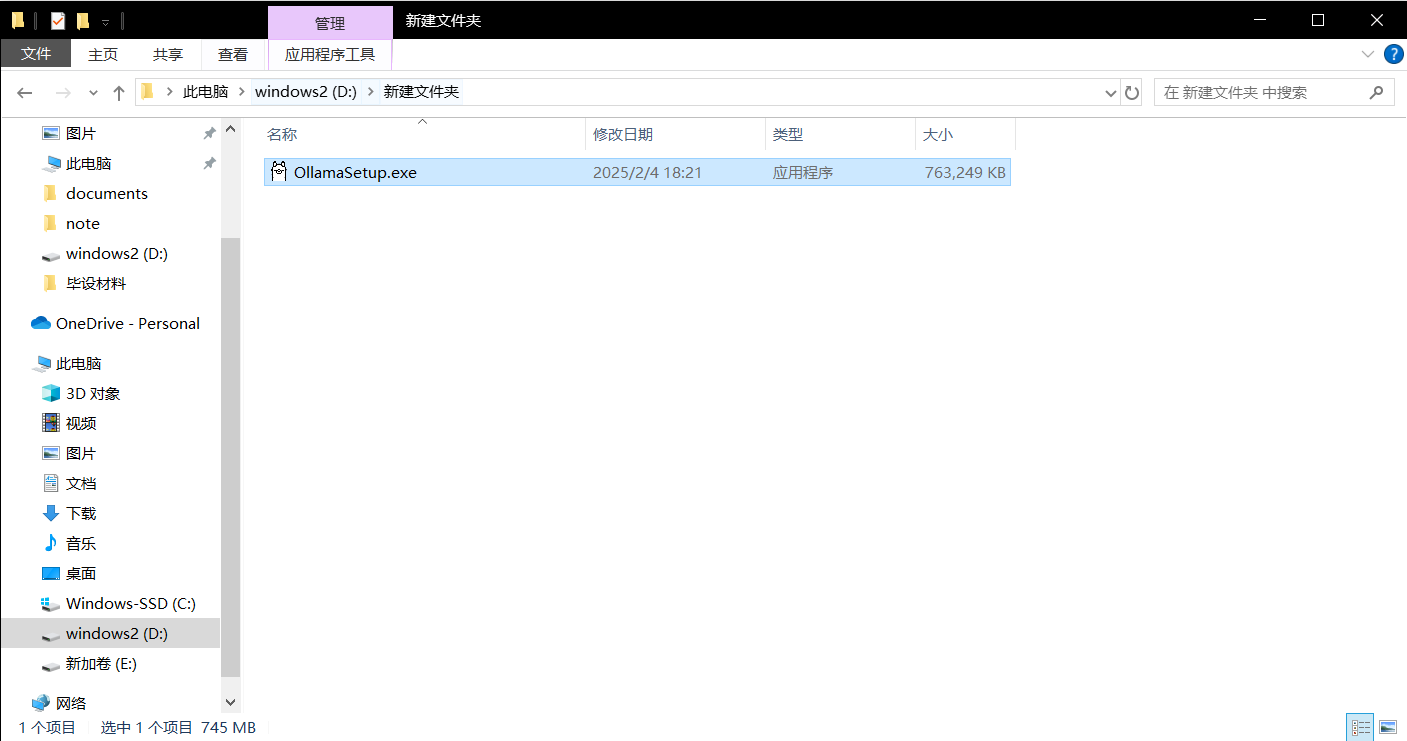

在您希望安装Ollama的磁盘上新建一个文件夹。例如,在D盘创建一个名为“Ollama”的文件夹:

D:\Ollama。 -

将Ollama的安装包移动或复制到这个新创建的文件夹中。

-

打开文件资源管理器,导航到包含Ollama安装包的文件夹(即上述例子中的

D:\Ollama)。 -

在文件夹路径栏输入

cmd,然后按回车键。这样会直接在当前路径下打开命令提示符窗口。

- 在打开的命令提示符窗口中输入以下命令,并确保将路径替换为您实际使用的路径:

OllamaSetup.exe /DIR=D:\Ollama - 按回车键执行命令,Ollama将会被安装到指定的目录。

改Ollama模型安装位置

为了更改Ollama模型的安装位置,您可以通过设置环境变量的方式来实现。具体步骤如下:

-

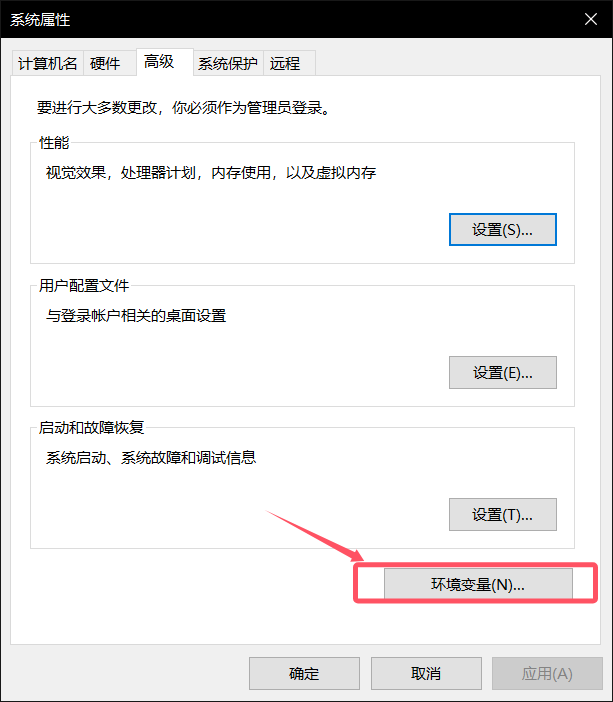

右键点击“此电脑”或“我的电脑”图标,然后选择“属性”。

-

在打开的窗口中,点击左侧的“高级系统设置”。

-

在“系统属性”对话框中,切换到“高级”选项卡,然后点击下方的“环境变量”按钮。

- 在环境变量窗口中添加一个新的系统变量:

-

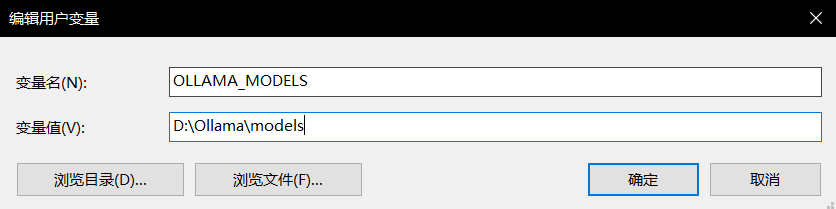

在“用户变量”部分,点击“新建”按钮。

-

变量名输入:

OLLAMA_MODELS -

变量值输入您希望存放Ollama模型的具体路径,例如:

D:\Ollama\models -

点击“确定”保存设置。

-

- 设置完成后,确保Ollama软件能够识别这个新的环境变量。通常情况下,如果Ollama支持通过环境变量配置模型存储位置,它将自动使用您指定的新路径来存储和访问模型文件。

请确保在执行上述步骤前已经创建好目标文件夹(例如D:\Ollama\models),以便顺利完成环境变量的设置。

Ollama使用

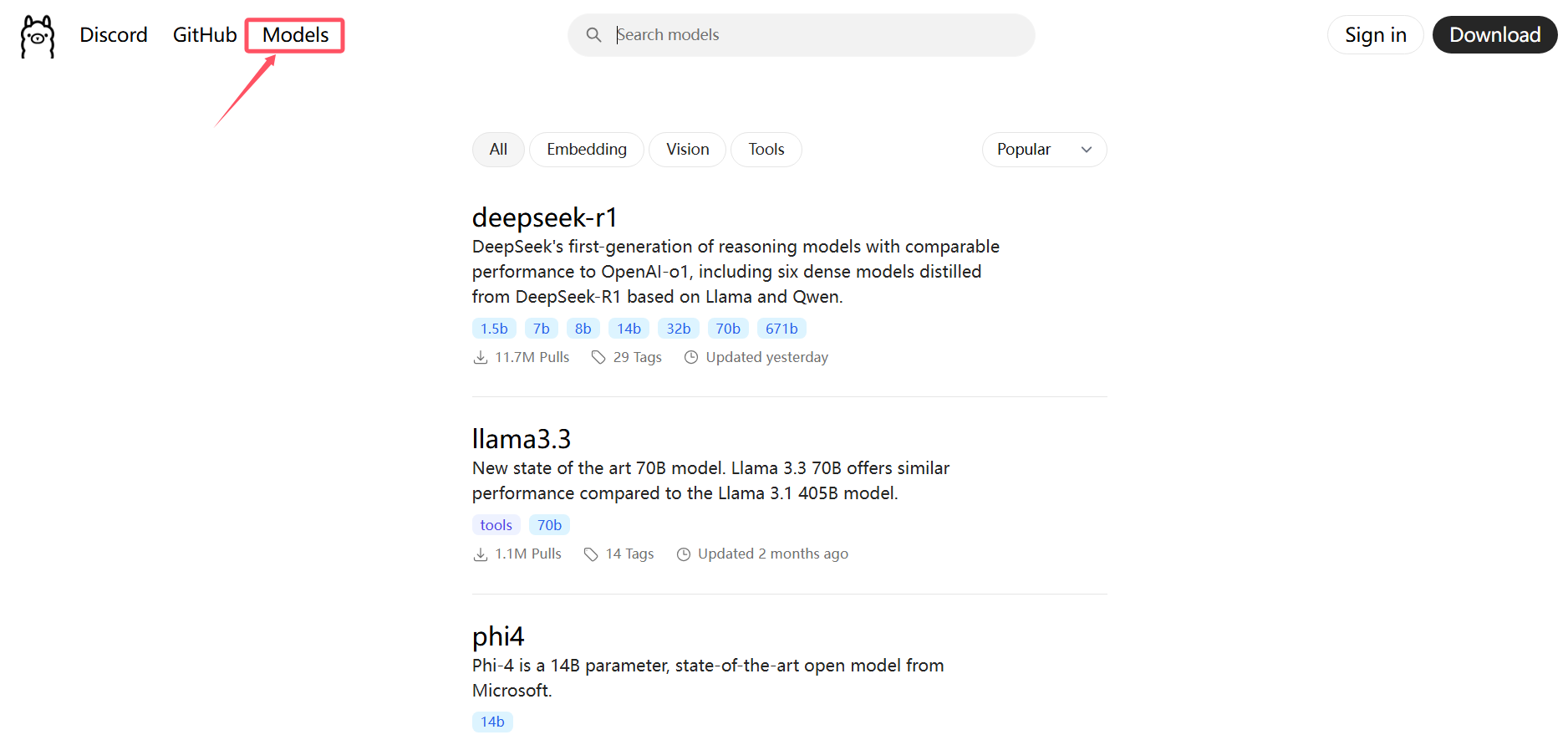

可以在Ollama官网查询模型

在命令行使用以下命令即可下载模型:

ollama run <model_name>

例如:ollama run deepseek-r1:7b

注:在下载过程中可能网速变慢,可以使用快捷键 Ctrl+C 来终止当前正在运行的命令,并重新运行即可解决

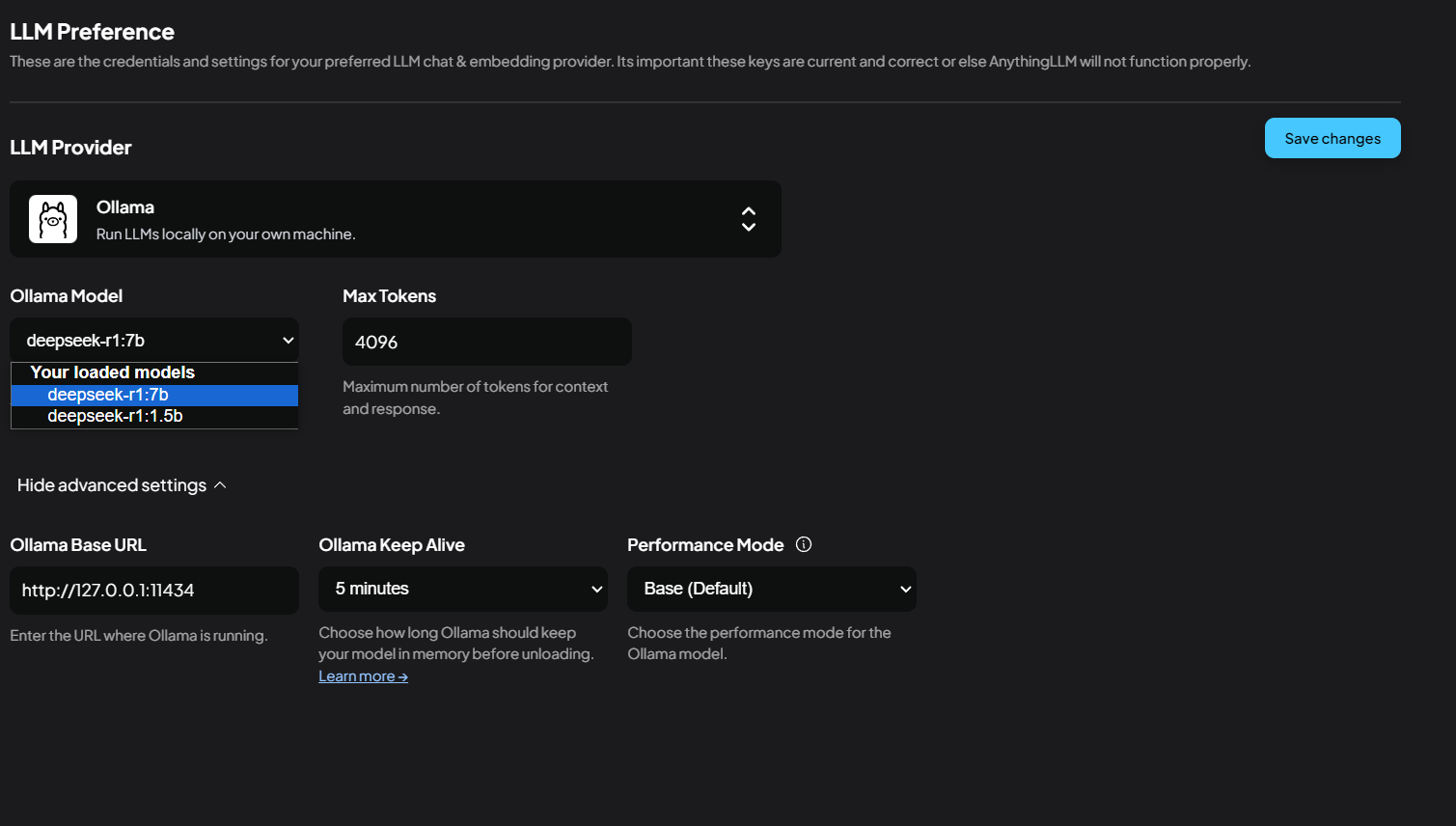

AnythingLLM配置

-

打开AnythingLLM,AnythingLLM可自动检测Ollama,选择模型

-

创建新的工作区

-

开始使用

在设计里面可以更改语言,主题,以及LLM配置等

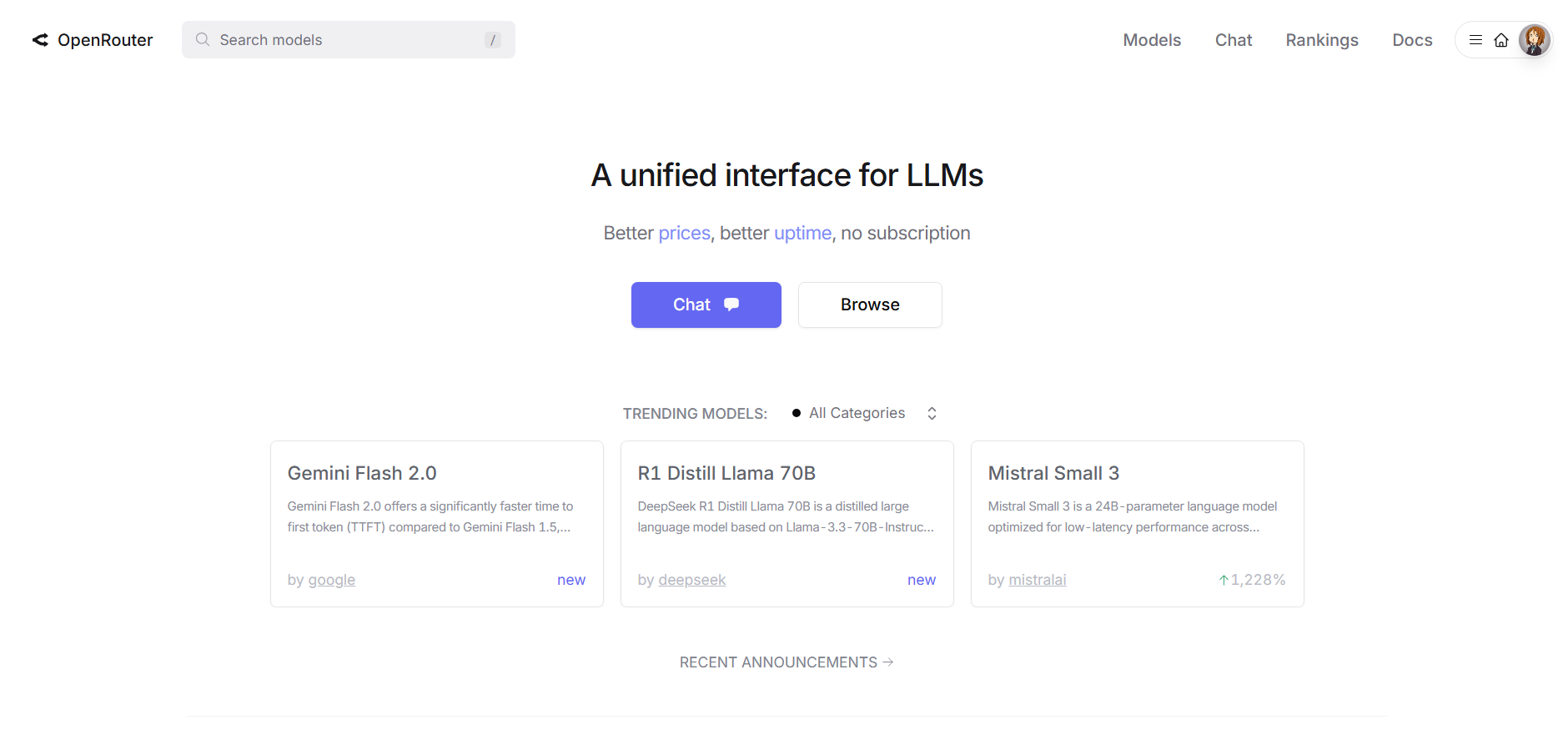

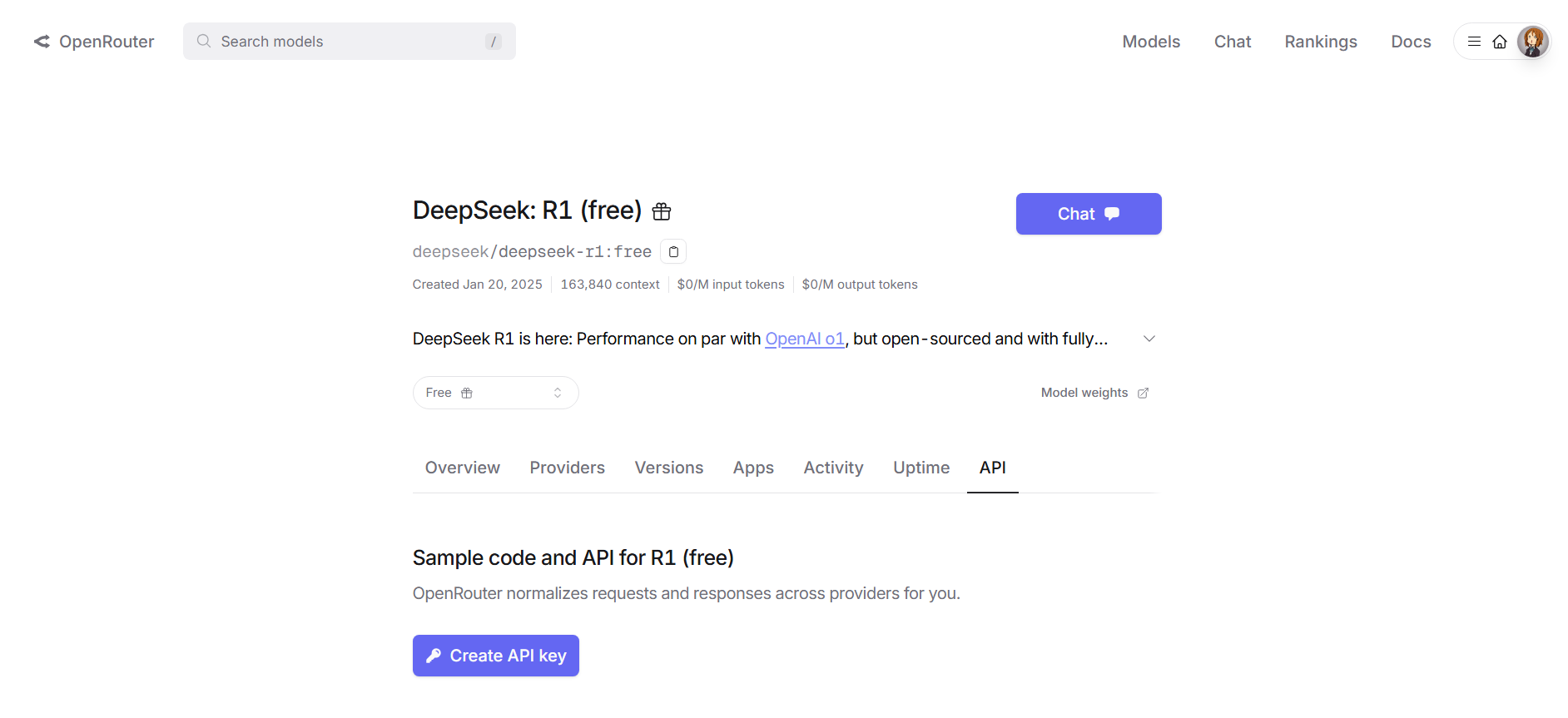

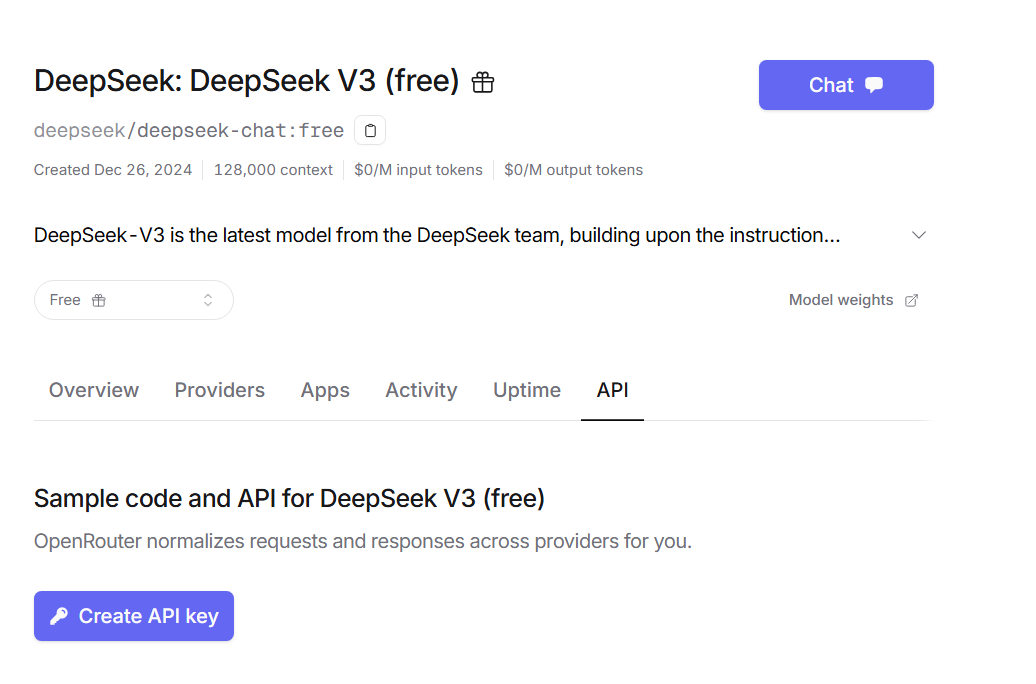

OpenRouter白嫖deepseekAPI(需VPN)

可以找到

DeepSeek: R1 (free),即671B版本

DeepSeek: DeepSeek V3 (free)

需要创建API Key

1. python代码(以DeepSeek: R1 (free)为例)

import requests

import json

response = requests.post(

url="https://openrouter.ai/api/v1/chat/completions",

headers={

"Authorization": "Bearer <OPENROUTER_API_KEY>", # 此处填入你自己的Key

"HTTP-Referer": "<YOUR_SITE_URL>", # Optional. Site URL for rankings on openrouter.ai.

"X-Title": "<YOUR_SITE_NAME>", # Optional. Site title for rankings on openrouter.ai.

},

data=json.dumps({

"model": "deepseek/deepseek-r1:free", # Optional

"messages": [

{

"role": "user",

"content": "介绍一下你自己"

}

]

})

)

# 解析JSON响应

response_json = response.json()

# 提取message中的content

try:

content = response_json['choices'][0]['message']['content']

# print(content)

# 将内容保存到Markdown文件

with open('output.md', 'w', encoding='utf-8') as f:

f.write(content)

print("内容已保存到 output.md 文件中")

except (KeyError, IndexError) as e:

print(f"Error extracting content: {e}")

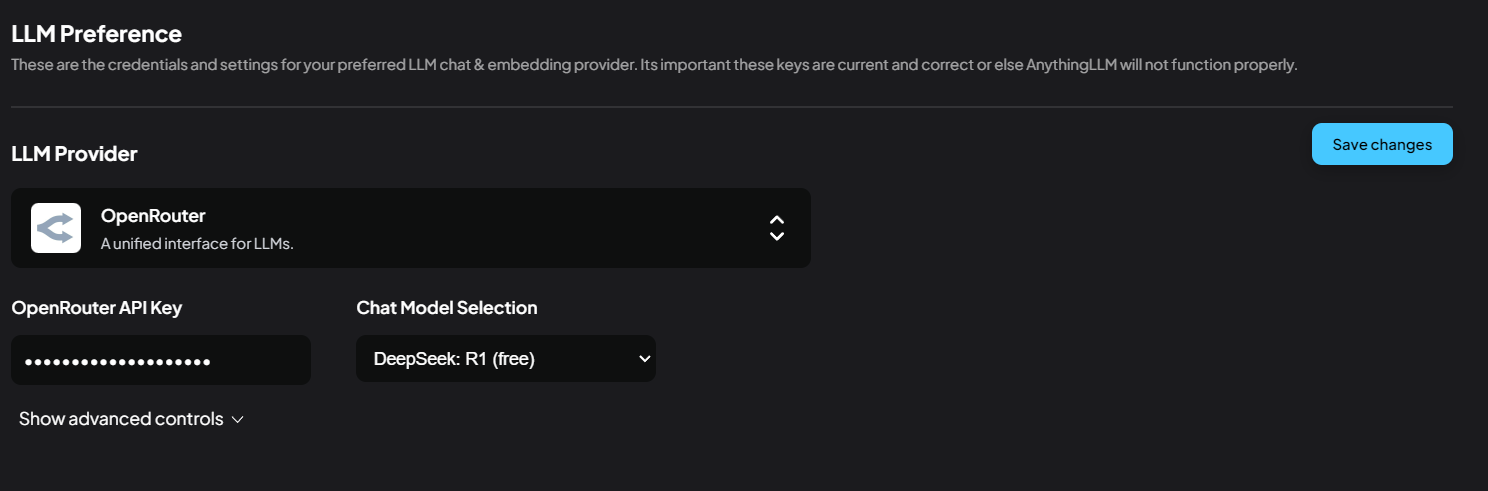

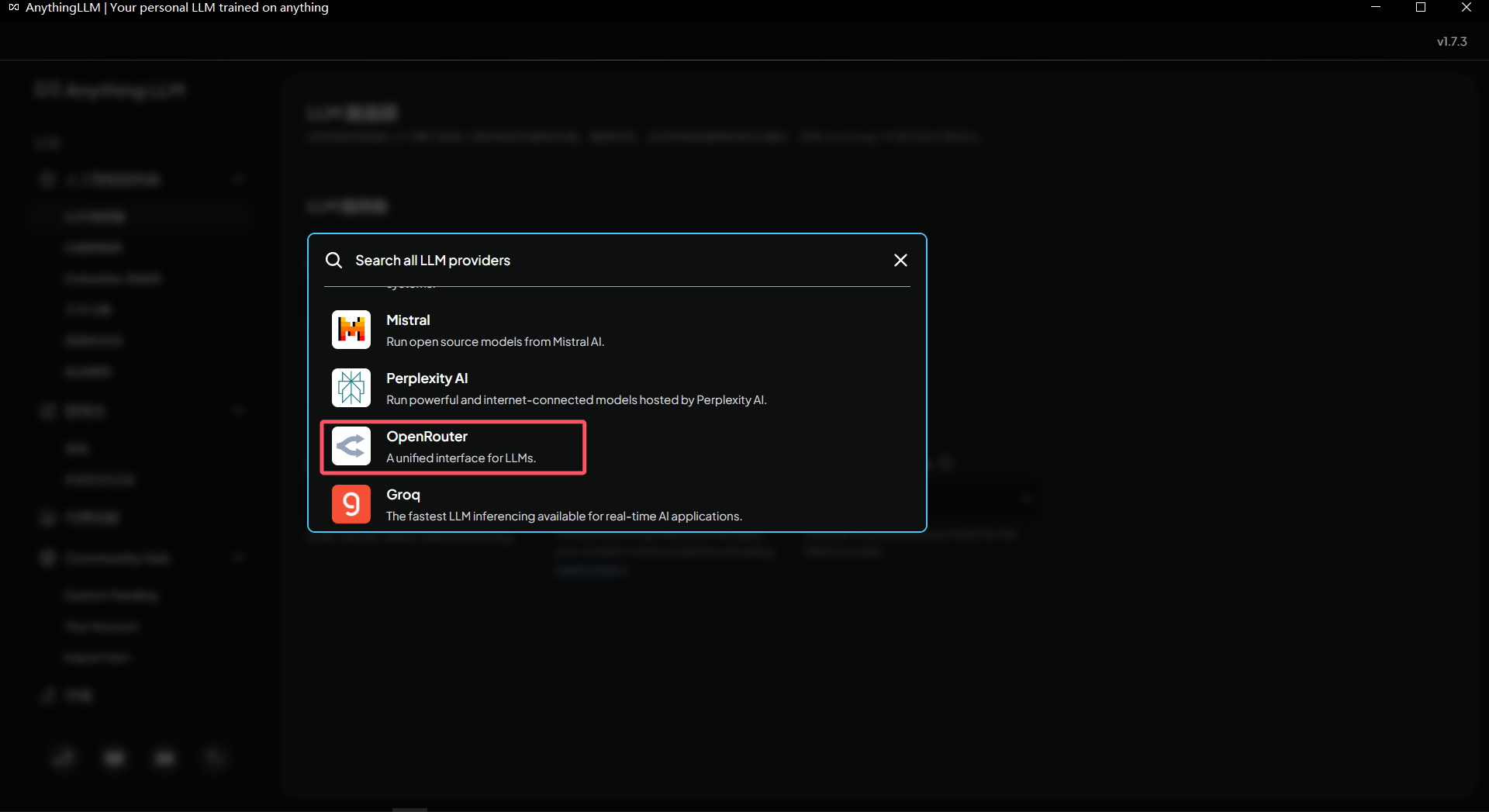

2. 配置到AnythingLLM

可以在 LLM Provider 里面找到 OpenRouter

接着输入API Key,选择模型即可使用